我猜閱讀第一篇的不是親友就是怪怪der人.

幾個前提問答,

以上兩題如果你都是YES

那我真的覺得你可以加我linkined 然後我幫你找工作 或你幫我找工作.

正文開始還是要談一個東西, 大爆炸的起點.

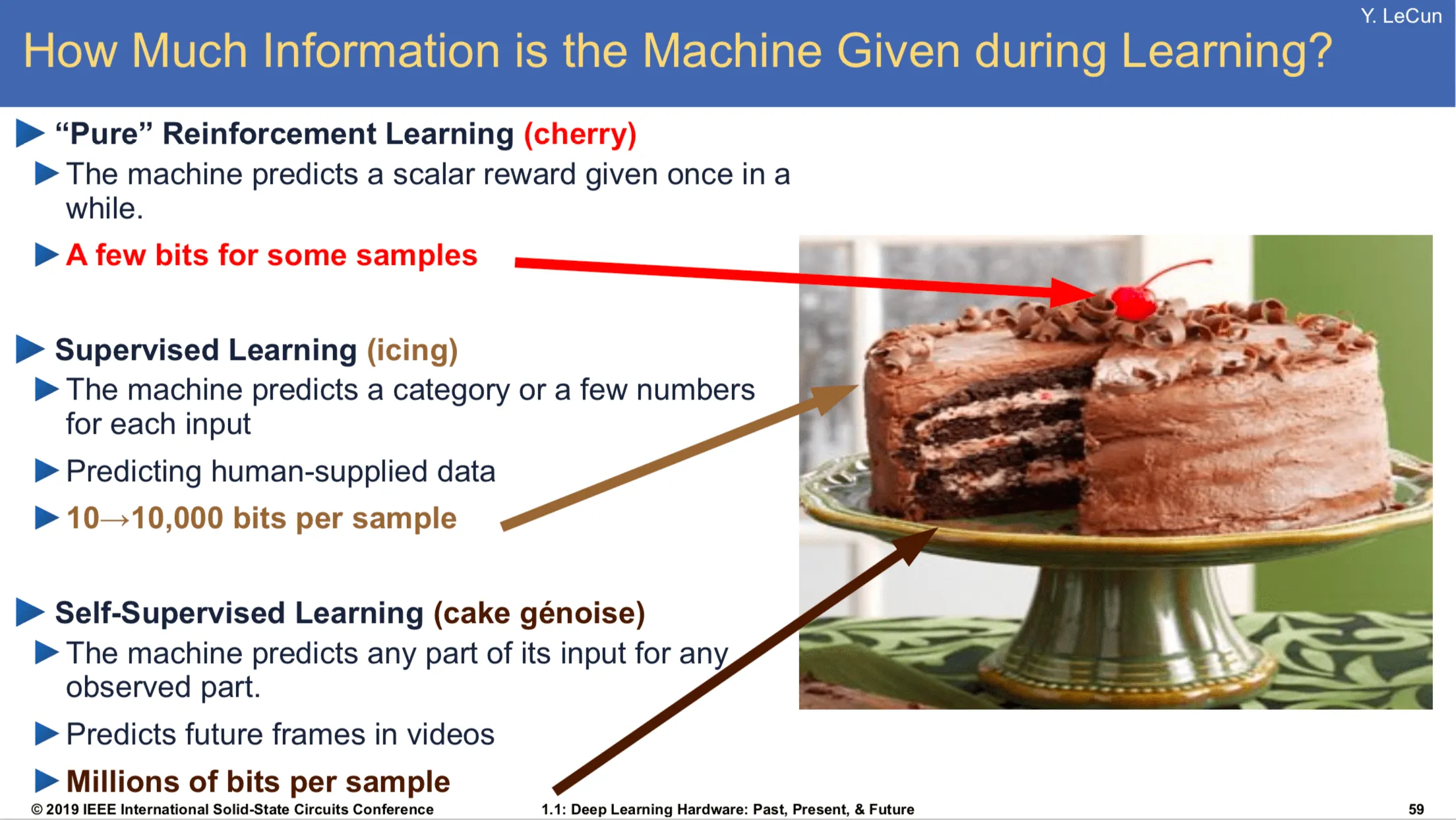

先幫大家查了 icing = 糖霜, cake genoise = 糕體

非常著名的蛋糕圖, 說明機器學習的資料量和問題分類. 共分3類 和教科書分的方法不一樣. 但這裡,以Yann LeCun為主.

我相信很多人都可以想像一個最簡單的machine learning的概念. 就是想像 黑箱子 如果我們手邊有已經標註過貓貓狗狗的圖片和標籤. 就是這張是貓/那張是狗的很多很多張照片.

訓練的model就是把圖片 -> 貓or狗, 這應該是最好理解的部分, 也就是糖霜那一層. 資料量是中等的. 但標注資料真的有夠貴, 肯定是跟不上資料產生速度. 所有FB/IG發的文章都是人類可訓練的一部分. 但實際上還有更多更多的資料量還沒被使用.

self-supervised, 也就是蛋糕最多最香的部分. 其實是轉化思考問題的本身. 就像是哼歌一樣. 我們希望模型可以有語感. 例如說, 我把某個字從句子裡挖空怎麼填應該是最舒服的.

冬X夏草 X一定是填🐛嘛

今天我就要XX你啦. XX可以填 嫁給, 也可以填打爆. 都對.

這樣轉換訓練任務就不需要人類去標註任何資料,只需要原原本本的資料, 隨機挖空就可以產生很多題目. 但和貓貓狗狗的任務不同, 這邊沒有正確一說, 因為XX可以填入多個不同答案但還是符合這個語言. 所以說大語言模型比較像是在哼歌, 會有好聽不好聽, 但你不會說誰誰誰哼歌哼的不對.

但核心就是改變任務的內容就多了很多資料可以訓練. 然後就是大力出奇蹟ㄌ

Take away.

你要有能力唬爛你的朋友, 蝦咪是蛋糕圖